保姆级教程!如何在本地安装和运行 DeepSeek R1 模型

DeepSeek R-1 是 DeepSeek-V3 模型的衍生版本,结合了监督微调(Supervised Fine-Tuning, SFT)和强化学习(Reinforcement Learning, RL),增强了推理能力、代码生成和回答复杂问题的能力。

为什么要在本地安装DeepSeek R-1

1.数据隐私:避免在线服务的数据收集问题,用户完全控制输入内容。

2.无需网络:支持离线工作,适用于断网环境或高隐私要求场景。

3.无使用限制:不像云服务那样有速率限制或付费墙。

4.可自定义:可以对模型进行微调,结合其他工具(如 Gradio)创建 UI。

如何在本地运行 DeepSeek R-1

我们使用 Ollama 来在本地运行 LLM。Ollama 是一款跨平台(macOS、Linux、Windows)的开源工具,可以运行大语言模型。

安装步骤

1、访问Ollama 官方网站,下载并安装软件。

2、运行以下命令检查安装是否成功:

ollama -v3、这应该会返回 Ollama 的版本号,否则需要检查安装过程是否正确。

4、搜索 DeepSeek R-1 模型:

进入 Ollama 的模型界面,搜索 "deepseek-r1"。

5、选择合适的模型大小:

a. DeepSeek R-1 提供多个不同参数规模的模型(从 5B 到 671B 参数)。

b. 建议 8B 参数的模型适用于 8GB VRAM 的 GPU,而更大的模型则需要更高的显存需求。

6、下载并运行模型:

ollama run deepseek-r1:8b7、a.这会下载大约 4.9GB 的模型文件,确保有足够的磁盘空间。

b.下载完成后,用户可以直接在终端输入问题与模型交互。

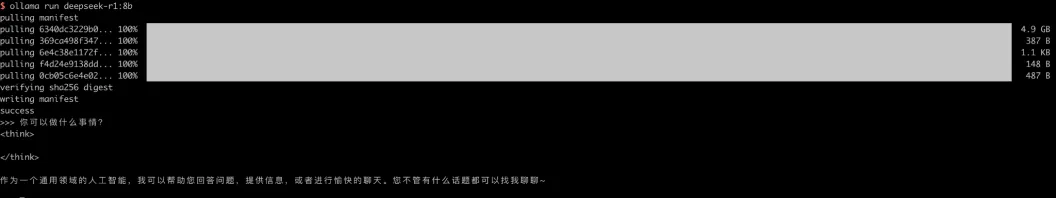

示例测试

Prompt: 你可以做什么事情?

Response: 为一个通用领域的人工智能,我可以帮助您回答问题,提供信息,或者进行愉快的聊天。您不管有什么话题都可以找我聊聊~运行成功后,用户可以在 完全离线 状态下与模型交互。

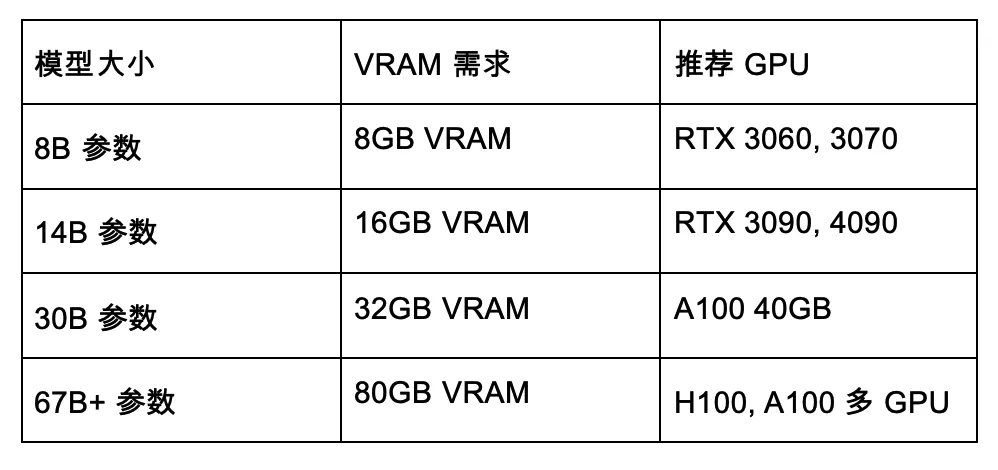

硬件要求

DeepSeek R-1 需要不同的硬件配置,具体取决于模型规模:

重要提示:

更大的模型可能需要多 GPU 并行计算。

Ollama 支持量化(quantization)技术,降低内存需求,提高运行效率。

更多AI知识请前往脑洞大开AI实验室官方网站

https://www.ai360labs.com

使用脑洞大开AI实验室AI对话功能,可访问

https://www.ai360labs.com/playground/chatService/new

点击底部分享、赞和在看,把好内容传递出去